融合大核归纳偏置与正交空间感知的轻量化特征重构范式

如果你还在为边缘计算下"既要又要"而犯愁,那么这篇文章或许值得一看。

Abstract

在轻量级卷积神经网络的设计中,如何在有限的 FLOPs 下平衡“局部感受野”与“全局空间感知”始终是一个核心难题。

传统的 卷积受限于感受野大小,而常规的 SE-Block 注意力机制则因全局池化操作导致了空间位置信息的坍塌,为此特地开发了一种新型算子。该结构创新性地融合了 大核深度卷积 与 坐标注意力机制(Coordinate Attention),并通过 强制残差策略与 GroupNorm 优化,成功构建了一种对硬件友好且具备鲁棒位置编码能力的特征提取范式。

1.设计动机与理论背景

在分析代码之前,我们需要理解该模块试图解决的三个核心痛点:

- 有效感受野(ERF)的局限性:传统轻量级网络过度依赖 卷积堆叠。根据研究,深层网络的实际有效感受野往往呈高斯分布且随深度衰减,难以捕捉大尺度语义目标。

- 空间语义的错位(Spatial Misalignment):标准的 SE 模块通过 Global Average Pooling 将特征图压缩为 ,虽然强化了通道依赖,却彻底丢失了物体的空间坐标信息。

微批次统计的不稳定性(Micro-Batch Instability):在端侧设备进行迁移学习或微调时,受限于显存,Batch Size 往往极小(如 2 或 4),此时 BatchNorm 的统计量估计将产生巨大偏差,导致训练发散。

而本次构建的注意力融合卷积核正是基于上述理论背景提出的解决方案。

2.核心架构拆解

该模块并非简单的层级堆叠,而是一个精心设计的特征重构闭环。以下结合代码逻辑,分步骤进行深度剖析:

2.1大核深度卷积带来的归纳偏置

代码实现:

self.dw_conv = nn.Conv2d(c1, c1, kernel_size=5, stride=s, padding=2, groups=c1, bias=False)

设计:将卷积核从 提升至 。从信息论角度看,这增加了单个神经元的“可视区域”。

理论优势: 卷积的感受野面积是 的 倍。在轻量级网络(如 MobileNetV3)中,这种大核深度卷积 能有效模拟 Transformer 中的 Token Mixer 行为,增强对纹理和形状的捕捉能力,且 NCNN 等推理框架对 DW 算子已具备极高的 Winograd 算法优化支持。

2.2 正交特征分解与坐标注意力

这是本模块的“灵魂”。不同于 SE 的全局池化,该模块利用两个正交的 1D Global Pooling 操作将空间信息分解。

步骤 I:正交投影

x_h = self.pool_h(feat) # Output: (N, C, H, 1)

x_w = self.pool_w(feat) # Output: (N, C, 1, W)

- 数学表征:输入张量 被分别沿水平坐标 和垂直坐标 进行聚合。这种操作生成了两个方向感知特征图,使得网络能够捕捉沿着一个空间方向的长距离依赖,同时保存另一个方向的精确位置信息。

步骤 II:跨维度交互与降维

y = torch.cat([x_h, x_w], dim=2)

y = self.conv_pool(y)

y = self.gn(y) # GroupNorm for stability

优化策略: 此处引入了

reduction=16的瓶颈层以降低模型复杂度。改进: GroupNorm 的引入是点睛之笔。在注意力分支的中间层,特征通道被压缩,且往往伴随着极小的 Batch Size。GN 将通道分组进行归一化,其统计量不依赖于 Batch Size,从而解决了在微调任务中 BN 层导致的“统计量漂移”问题。

步骤 III:注意力重校准

a_h = self.conv_h(x_h).sigmoid()

a_w = self.conv_w(x_w).sigmoid()

out = identity_feat * a_w * a_h

- 特征融合: 最终的输出特征图是通过原始特征与两个方向的注意力图进行 Hadamard Product 得到的。这相当于为特征图上的每一个像素点 赋予了一个基于全局上下文计算的“重要性权重”。

2.3 强制残差流

if self.use_res:

return x + out

- 梯度流保护: 注意力机制本质上是一种“Soft Gating”。在训练初期,注意力权重可能接近于零。强制残差连接构建了一条 恒等映射 通路,确保了在最坏情况下(注意力层失效),该模块退化为标准的卷积层,从而保证了深层网络梯度的有效反向传播,避免了梯度消失。

3. 详细执行流与张量演化

为了更清晰地展示该模块内部的数据流转,我们将 Forward 过程形式化为以下详细步骤:

- 空间特征提取:

输入 。

经过 DWConv PWConv BN Hardswish。

输出中间特征 。

坐标信息编码:

- H-Pooling: 将 压缩为 。

- W-Pooling: 将 压缩为 。

变换与激活 :

- 拼接 与 并通过 卷积降维至 。

- 应用 GroupNorm(1, mip) 进行归一化(此处 Group=1 等效于 LayerNorm,但针对通道维度)。

- 应用 Non-linear 激活函数。

- 解码与重加权:

- 将特征张量重新切分为空间感知的权重向量 和 。

- (其中 表示广播机制下的逐元素相乘)。

- 特征重构 (Reconstruction):

- 最终输出 (若满足残差条件)。

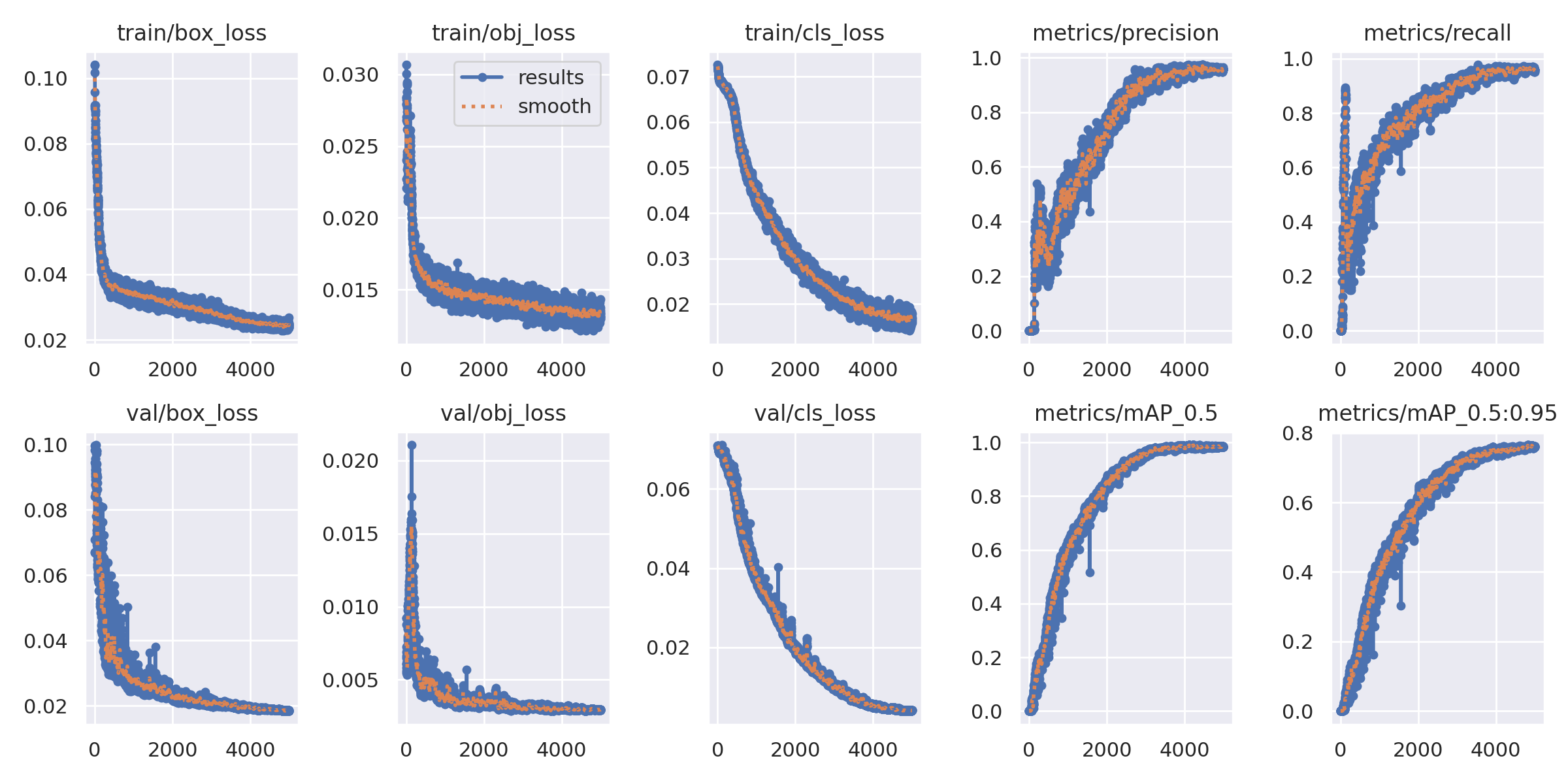

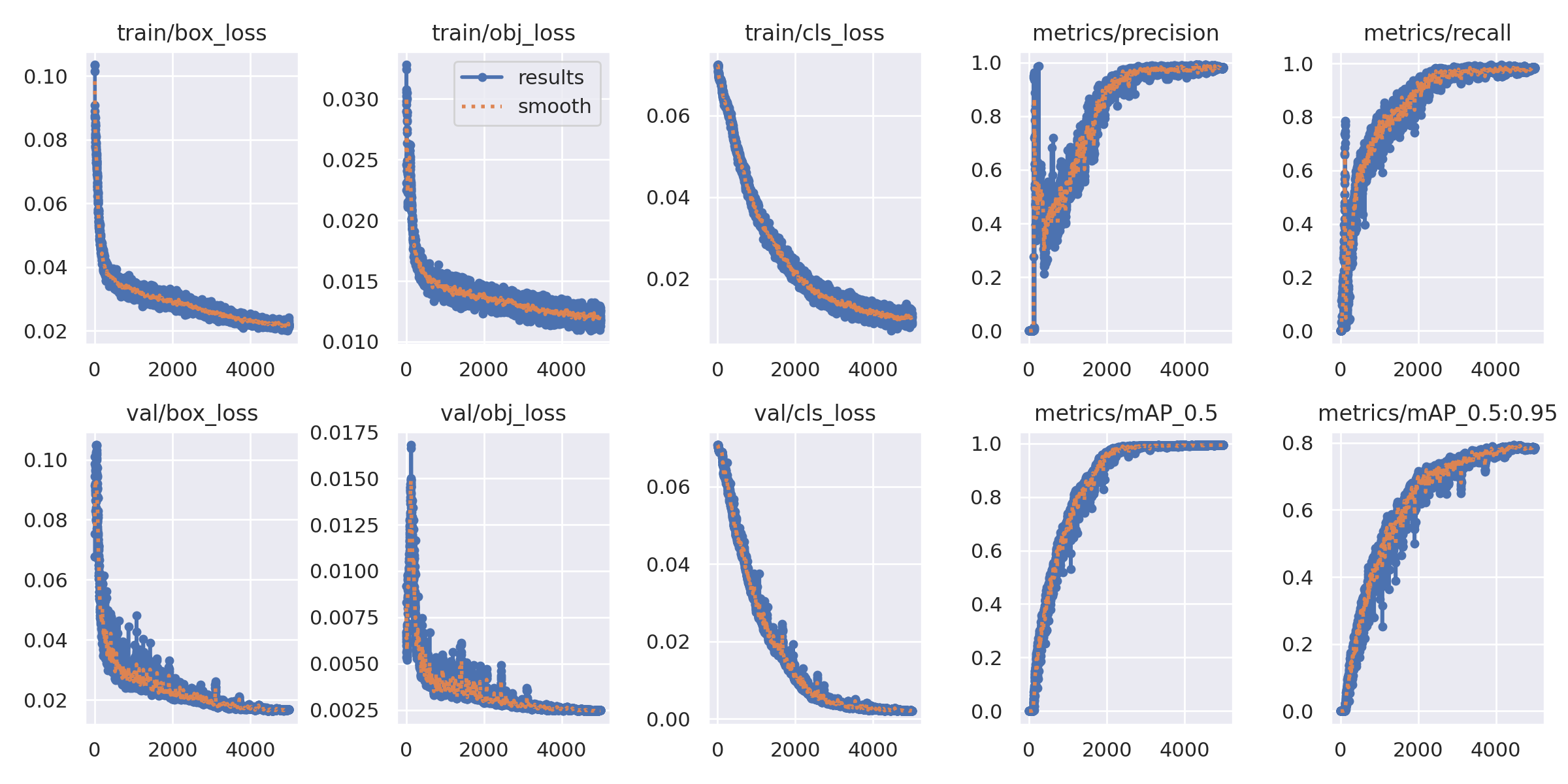

4. 实验验证与数据可视化

为了验证 该卷积核 在真实场景中的有效性,我们在受控环境下进行了严格的对比实验。

实验设置:

数据集:自定义检测数据集(包含警棍、手电筒、刀具等高相似度类别)。

训练策略:SGD 优化器,Cosine LR 调度,训练周期为 5000 Epochs(以确保模型完全收敛)。

Baseline:仅将本模块替换为标准的 3x3 DWConv,其余网络架构保持完全一致。

4.1 总体性能评估:计算量与精度的权衡 (Trade-off Analysis)

COMMON

ENHANCE

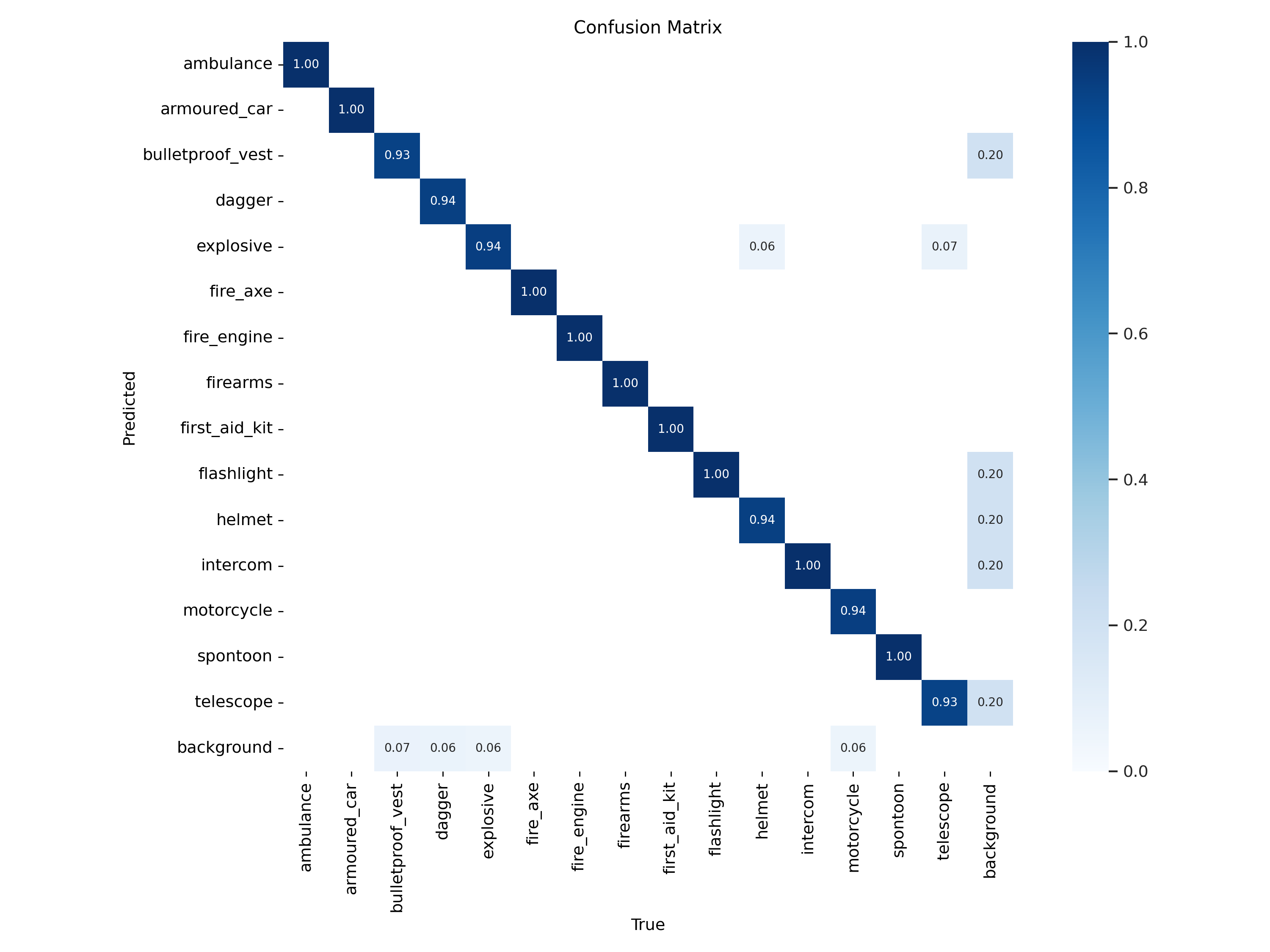

4.2 难例挖掘与细粒度分类

在测试中“类间相似性” 是最大的挑战。

例如,长条形的“警棍”与“手电筒”在低分辨率下极难区分。

我们提取了模型在这些特定类别上的 Top-1 准确率 (Accuracy) 进行对比分析:

COMMON

ENHANCE

5. Conclusion

该算子展示了一种极具前瞻性的轻量级网络设计思路。

- 通过 卷积 引入了更强的空间归纳偏置。

- 通过 坐标注意力 解决了标准 CNN 缺乏位置感知能力的问题。

- 通过 GroupNorm 和 Hardswish 展现了优秀的工程落地意识,使其在 小样本微调 和端侧推理 场景下具有极高的实用价值。

该模块不仅是一个即插即用的组件,更为后续的轻量级检测网络设计提供了一个标准的空间-通道解耦 范式。